Invarianza de medición: su importancia en psicología y algunas direcciones futuras para su uso

El estudio del significado y la comprobación de las puntuaciones obtenidas por los tests, constituye uno de los elementos de la validez (Elosua, 2003). Un aspecto central en toda medición es que esta debe medir de forma idéntica los constructos, sobre todo cuando el objetivo es comparar grupos, comparar el significado del constructo en diferentes ocasiones de medición en un mismo grupo e incluso en grupos culturales distintos (Putnick y Bornstein, 2016). Cuando el resultado de una medición cuenta con esta característica, se puede afirmar que las puntuaciones son invariantes. Si podemos demostrar la invarianza de medición, los participantes, sean estos de diferentes grupos (culturales, sexo, entre otros), interpretan de una misma forma los ítems bajo un mismo factor latente (Byrne, 2008).

En el caso de no demostrar invarianza de medición de los constructos en diferentes grupos, estos son concebidos de forma diferente o se le asignan diferentes significados, que es una razón suficiente para no poder establecer comparaciones. Sin embargo, en la actualidad, estudios reportan resultados comparativos omitiendo prerrequisitos como las medidas de invarianza de medición (Dominguez-Lara, 2016).

Al respecto, Elosua (2005) expresa lo siguiente:

No tendría sentido contraponer puntuaciones de personas pertenecientes a dos grupos culturales en un constructo que no tuviera la misma representación (significado) en las dos culturas. Tampoco sería correcto interpretar unívocamente los resultados de un test (o formas de éste) si su aplicación en dos contextos se asocia con errores de medida diferentes. La pertinencia de ambos usos está supeditada a la invarianza de medida de las puntuaciones (p. 356).

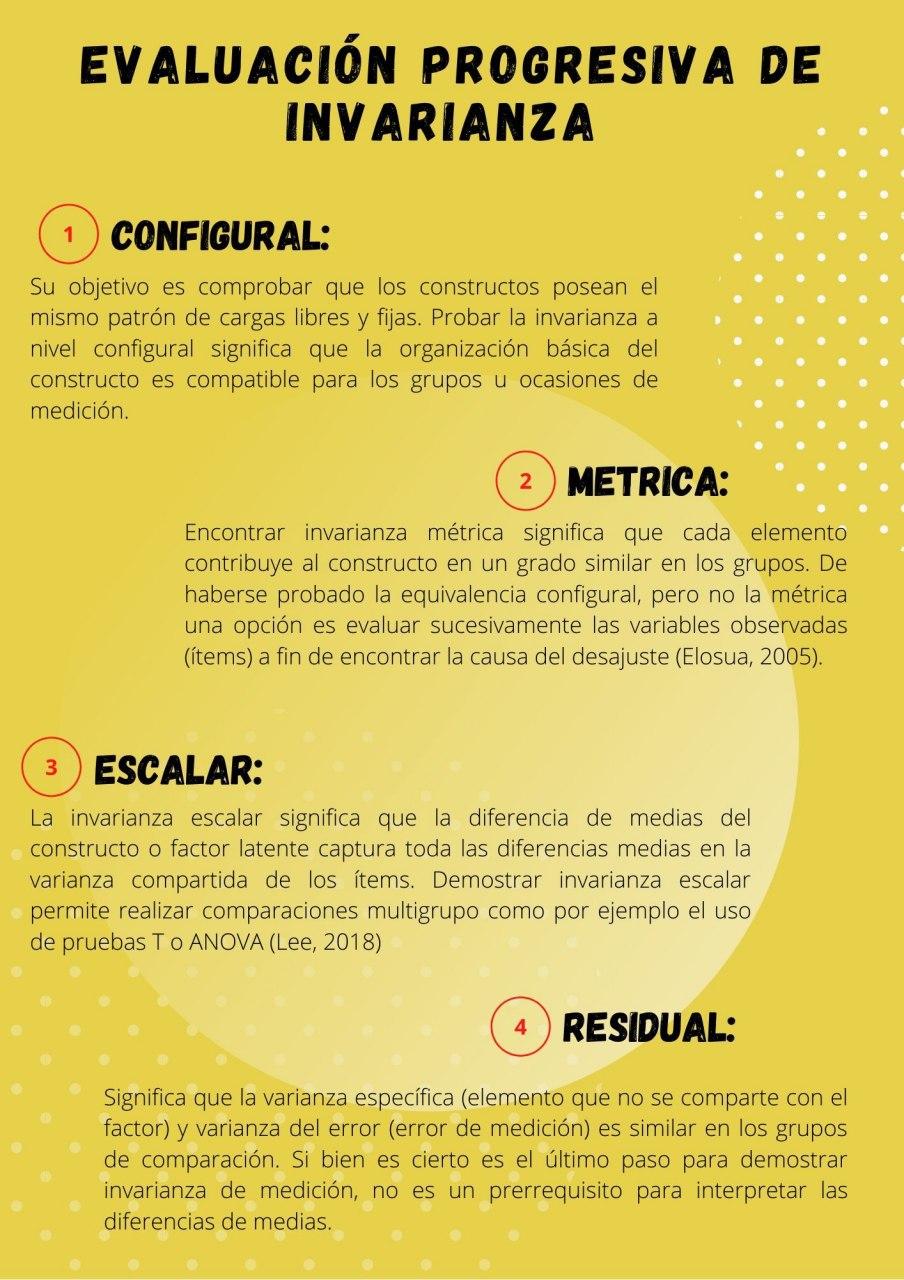

Pruebas de invarianza de medición

Para el estudio de la invarianza de medición se utilizan las aproximaciones de la teoría de respuesta al ítem (IRT) y el modelamiento de ecuaciones estructurales (SEM) e incluso existen aproximaciones que conjugan ambos enfoques (Putnick y Bornstein, 2016). El estudio desarrollado por Putnick y Bornstein (2016) se enmarca dentro de la metodología SEM, utilizando el análisis factorial confirmatorio (CFA). Asimismo, describe los niveles de invarianza (configural, métrica, escalar y residual) y usa como ejemplo de análisis, para ilustrar cada paso de los niveles de invarianza, un estudio comparativo entre padres de Estados Unidos y China que tiene como variables latentes a la calidez (5 ítems) y el control (5 ítems).

Estudios de invarianza de medición

Los estudios que reportan invarianza de medición, con el transcurrir de los años, han aumentado de forma significativa; sin embargo, estos no están exentos de dificultades. Diversos problemas metodológicos han sido reportados en cuanto a la ejecución de pruebas de invarianza, las principales dificultades mencionadas por Putnick y Bornstein (2016) son:

- Número y orden de las pruebas requeridas para establecer invarianza de medición

- Criterio de evaluación de ajuste del modelo

- Invarianza parcial

- Características de la muestra

En este sentido, el estudio realizado por Putnick y Bornstein (2016), en el que se exploró las prácticas actuales para probas medidas de invarianza, encontró 126 artículos en el período de un año (2013-2014) con más de 250 pruebas de medida de invarianza. Encontraron que todos los estudios reportaron invarianza configural, un 86% incluyó invarianza métrica, un 86% invarianza escalar y solo un 41% reportó invarianza residual.

Este panorama representa la importancia que va cobrando la invarianza de medición en los estudios de investigación en psicología. Reportar la invarianza no solo asegura la pertinencia de inferencias en cuanto a estudios comparativos, sino que, reportar la invarianza de medición podría también brindar al investigador información sobre cómo diferentes grupos conciben el constructo que está siendo medido (Putnick y Bornstein, 2016). Asimismo, se alienta a los editores que consideren el uso de pruebas de invarianza en estudios que establezcan comparaciones (Dominguez-Lara, 2016; Putnick y Bornstein, 2016), evitando así sesgos en la medición correspondientes a diferencias en variables distintas al factor latente medido.

Direcciones futuras

Las direcciones futuras, en cuanto el estudio de la invarianza de medición, apuntan a mejoras en el ámbito investigativo y teórico, que desde la óptica de Putnick y Bornstein (2016) son las siguientes:

a. Sensibilidad conceptual y estadística

Entendida como la precisión de las pruebas de invarianza para identificar diferencias significativas en distintos grupos o momentos de medición. Asimismo, enfatiza en conocer el significado de las pequeñas violaciones en la invarianza de medición en el proceso de construcción de un instrumento y/o interpretación de los resultados del mismo. Resulta necesario el estudio del significado de cada violación de invarianza, sobre todo si las pequeñas violaciones en el estudio de la invarianza son motivo suficiente para no poder establecer comparaciones grupales o temporales.

b. Invarianza a través de variables continuas

Las aplicaciones del estudio de invarianza de medición encuentran dificultades cuando se intenta estudiarla en variables ordinales o continuas, sobre todo cuando no es sencillo agruparlas en categorías definidas. Este panorama constituye la necesidad de investigación del desempeño de las pruebas de invarianza en diferentes condiciones contando, para su realización, con diversos métodos de estimación.

c. Técnicas estadísticas para analizar datos no invariantes

Cuando una construcción muestra puntuaciones no invariantes o parcialmente invariantes, no se posee un panorama claro sobre cómo continuar con el análisis e incluso sobre cómo interpretar los datos no invariantes. En este sentido, se sugiere investigar sobre los enfoques estadísticos que podrían utilizarse en casos de manejar datos que poseen una invarianza parcial o son totalmente no invariantes.

Referencias:

Byrne, B. (2008). Testing for multigroup equivalence of a measuring instrument: A walk through the process. Psicothema, 20(4), 872-882.

Dominguez-Lara, S. (2016). Comparing self-concept between groups, bias or differences?: Comments to Castillo et al. Revista chilena de pediatría, 87(5), 436. https://doi.org/10.1016/j.rchipe.2016.03.003

Elosua, P. (2003). Sobre la validez de los test. Psicothema, 15(2), 315-321.

Elosua, P. (2005). Evaluación progresiva de la invarianza factorial entre las versiones original y adaptada de una escala de autoconcepto. Psicothema, 17(2), 356-362.

Lee, S. T. (2018). Testing for measurement invariance: Does your measure mean the same thing for different participants? APS Observer, 31(8), 32–33.

Putnick, D. L., Bornstein, M. H. (2016). Measurement invariance conventions and reporting: The state of the art and future directions for psychological research. Developmental Review, 41, 71-90. https://doi.org/10.1016/j.dr.2016.06.004s