¿Cómo reportar revisiones sistemáticas y meta-análisis?

El meta-análisis es una metodología que, al igual que la revisión sistemática, permite integrar los resultados de estudios primarios de un tema en particular, diferenciándose de esta por la utilización de métodos estadísticos para analizar y resumir dichos resultados (Ato, López y Benavente, 2013). En la actualidad, la psicología, al igual que otras disciplinas, se nutre de este tipo de trabajos para sintetizar la investigación acumulada sobre un tópico o evaluar la pertinencia de las intervenciones. En conclusión, mediante su revisión se busca la mejor evidencia científica para tomar decisiones sobre una problemática determinada.

Sin embargo, la forma en cómo se reportan, es decir, cómo se especifican los pasos y las decisiones tomadas en su elaboración, no siempre es la más adecuada. Este déficit en la calidad del reporte representa un problema debido a que las conclusiones extraídas de las revisiones sistemáticas y meta-análisis pueden tener un impacto sustancial, tal como escoger un tratamiento por encima de otros.

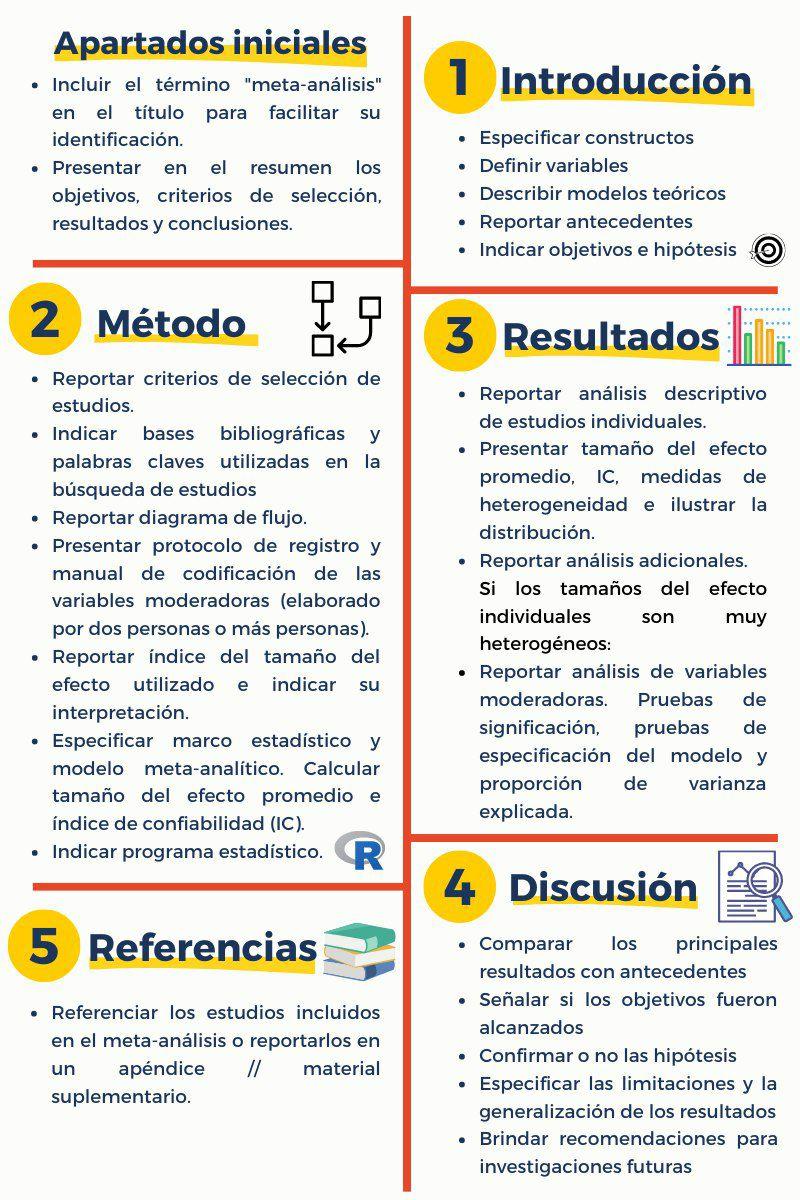

Por tal motivo, Rubio-Aparicio, Sánchez-Meca, Marín-Martínez & López-López (2018) brindan una serie de recomendaciones que puedan ser complementarias a las guías ya existentes como PRISMA (Preferred Reporting Items for Systematic reviews and Meta-Analyses) o AMSTAR (Evaluación de Múltiples Revisiones Sistemáticas) usadas en medicina, y MARS (Assessment of Multiple SysTemAtic Reviews) empleada en psicología. Estas sugerencias se estructuran de acuerdo a los cinco (05) apartados principales de un meta-análisis: Introducción, método, resultados, discusión, y referencias. Además, se agrega un par de sugerencias en relación con apartados iniciales como título y resumen.

Con relación al esquema, se pueden precisar ciertos puntos sobre el apartado de método:

Criterios de selección de los estudios: corresponden a la metodología PICO: participantes, intervención, control y resultado. Herramienta recomendada: https://bit.ly/3iLMPzP

Búsqueda de los estudios: el diagrama de flujo permite resumir el proceso de cribado y selección de trabajos. Herramienta recomendada: https://bit.ly/2ZPTxxk

Codificación de las variables moderadoras: estas pueden dividirse en sustantivas (relacionadas con el objeto de estudio), metodológicas (relacionadas al tipo de diseño y métodos aplicados), y extrínsecas (que no fueron consideradas en la formulación del estudio, pero que afectan a los resultados), asimismo, el manual de codificación debe ser elaborado por dos o más participantes para garantizar la fiabilidad del proceso.

Cálculo de un índice del tamaño del efecto: los índices dependen del diseño y de la naturaleza de las variables, siendo los más frecuentes los índices d (compara dos grupos en una o más variables continuas), índices r (analiza el grado de asociación de dos variables continuas) e índices de riesgo (sintetiza resultados dicotómicos).

Análisis estadístico: Especificar el marco estadístico (frecuentista o bayesiano) y el modelo meta-analítico (de efecto fijo u de efectos aleatorios), explicar la razón de su uso. Calcular el tamaño del efecto promedio y el intervalo de confianza. Presentar gráficos. Reportar los análisis adicionales, en caso de haberse aplicado. Incluir el programa estadístico [Herramientas recomendadas: Jamovi mediante el módulo MAJOR, y R a través del paquete “metafor”].

Finalmente, cabe indicar que la descripción detallada de cada una de las fases busca garantizar la transparencia y replicabilidad del proceso, posibilitando así que otros investigadores realicen una evaluación crítica de los resultados obtenidos

Referencias

APA Publications y Communications Board Working Group on Journal Article Reporting Standards. (2008). Reporting standards for research in psychology: Why do we need them? What might they be? American Psychologist, 63, 839-851. https://doi.org/10.1037/0003-066X.63.9.839

Ato, M., López-García, J., & Benavente, A. (2013). Un sistema de clasificación de los diseños de investigación en psicología. Anales de Psicología, 29(3), 1038-1059. https://doi.org/10.6018/analesps.29.3.178511

Moher, D., Liberati, A., Tetzlaff, J., Altman, D. G., y Prisma Group. (2009). Preferred reporting items for systematic reviews and meta-analyses: The PRISMA statement. PLoS Medicine, 6, e1000097. https://doi.org/10.1371/journal.pmed.1000097

Rubio-Aparicio, M., Sánchez-Meca, J., y Marín-Martínez, J. (2018). Recomendaciones para el reporte de revisiones sistemáticas y meta-análisis. Anales de Psicología, 34(2), 412-420. https://doi.org/10.6018/analesps.34.2.320131

Shea, B. J., Grimshaw, J. M., Wells, G. A., Boers, M., Andersson, N., Hamel, C., y Bouter, L. M. (2007). Development of AMSTAR: a measurement tool to assess the methodological quality of systematic reviews. BMC Medical Research Methodology, 7, 10. https://doi.org/10.1186/1471-2288-7-10